产品详情:

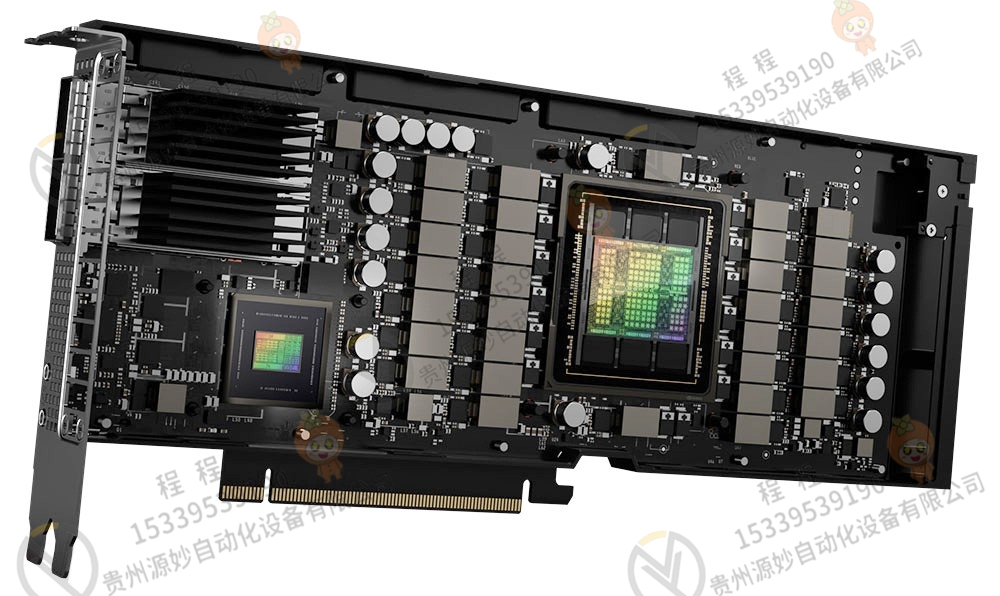

借助NVIDIA H100 Tensor Core GPU,为每个工作负载带来。的性能、可扩展性和安全性。借助NVIDIA NVLink交换机系统,多可以连接256个H100 GPUs来加速亿亿级工作负载。GPU还包括一个专用的转换器引擎来解决万亿参数的语言模型。H100的综合技术创新可以将大型语言模型(LLM)的速度提高到上一代的30倍,从而提供业界。的对话式人工智能

实时深度学习推理

人工智能解决了广泛的商业挑战,使用了同样广泛的神经网络。一个伟大的人工智能推理加速器不仅要提供高的性能,还要具有加速这些网络的多功能性。

H100扩展了NVIDIA市场。的推理领导地位,其多项进步将推理速度提高了30倍,并提供了低的延迟。第四代张量内核加快了所有精度,包括FP64、TF32、FP32、FP16、INT8和现在的FP8,以减少内存使用并提高性能,同时仍然保持LLM的精度。

亿亿次高性能计算

NVIDIA数据中心平台持续提供超越摩尔定律的性能增益。H100新的突破性人工智能功能进一步增强了HPC+人工智能的能力,为致力于解决世界上重要挑战的科学家和研究人员缩短了发现时间。

H100将双精度张量内核的每秒浮点运算次数(FLOPS)提高了三倍,为HPC提供了60万亿次FP64计算。人工智能融合的HPC应用还可以利用H100的TF32精度,在零代码更改的情况下,实现单精度矩阵乘法运算的petaflop吞吐量。

H100还具有新的DPX指令,在动态编程算法(如用于DNA序列比对的Smith-Waterman和用于蛋白质结构预测的蛋白质比对)上,性能比A100高7倍,比CPU快40倍。

PDPX指令比较NVIDIA HGX H100 4-GPU与双插槽32核IceLake

英伟达A800 播报 编辑 讨论 上传视频 图形处理单元处理器 英伟达A800是NVIDIA公司生产的显卡,是为了解决美国商务部的半导体出口新规,以取代A100 GPU,已经在2022年三季度起投产。 [1] 新的A800可以替代A100,两者都是GPU(图形处理单元)处理器。芯片经销商OMNISKY容天官网介绍的英伟达A800 GPU信息显示,新的芯片数据传输速率为每秒400GB,低于A100的每秒600GB,代表了数据中心的性能明显下降。而且,A800支持内存带宽。高达2TB/s,其他参数变化不大。

客服1

客服1